Samstagmorgen 10 Uhr, es klingelt an der Tür, das Känguru der werte Herr Nachbar wünscht einen schönen Tag und fragt, ob man sich die Versandkosten für Akkus als Ergänzung des jeweils eigenen Balkonkraftwerks teilen möchte. Sehr zuvorkommend, aber lohnt sich das eigentlich? Nun was soll man machen, nachdem das Wetter ja nun schon ausgewertet ist, wird es ja vielleicht mal wieder Zeit für eine Datenanalyse. Also ran an den Speck. Glücklicherweise ächzt das heimische NAS schon seit Jahresbeginn unter einer minutenscharfen Erfassung von Solar- und Netzstrom, woraus sich auch der eigene Verbrauch ermitteln lässt. Da drängt sich ja gerade zu auf, eine kleine Simulation zu basteln, die das ganze mal mit Akku durchrechnet.

Streamst du noch oder erfreust du dich schon an Hardwarebuttons mit Linux?

Vor einer Weile lief mir die „MX Creative Console“ von Logitech über den Weg und ich dachte mir wie geil, ich will auch echte Tasten am Schreibtisch haben! (Wenigstens einmal im Leben ein Gefühl von Kontrolle!) Doch dann fiel mein Blick auf den Preis und das Gefühl von Kontrolle war schneller wieder weg als der UPS-Lieferbote, wenn er was von „5. Stock ohne Aufzug“ hört. Doch die Neugierde ließ mich nicht los, also machte ich mich auf die Suche, das „Stream Deck Rabbit Hole“ zu ergründen. Und wie sich herausstellte, gibt es neben Logitech und Elgato – dem Quasi-Marktführer – auch noch jede Menge weitere Decks. Zeit also, ein solches mit der eigenen Home Automation zu verheiraten!

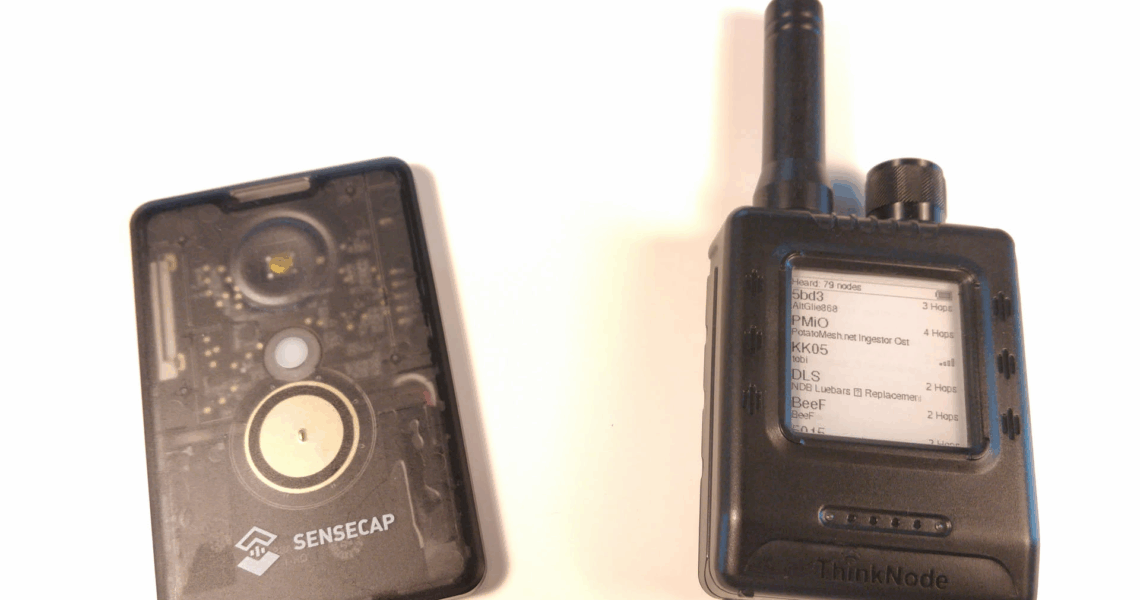

Meshtastic: die dezentrale Rettung für Lora?

Wer hätte gedacht, dass Lora bzw. LoraWAN mittlerweile schon über 10 Jahre alt sind? Zuletzt ist es gefühlt ruhiger geworden um das Protokoll, auch in der Berliner Community bewegt sich nicht mehr sonderlich viel – sicherlich auch durch die Abspaltung von Helium, die doch recht komplizierte Konfiguration von Clients (SF9? SF12? Version 1.0.1? 1.0.2? 1.1.0? …? Rev A der regionalen Parameter oder doch Rev B? Support Class B? Class C? Was war noch gleich die Home NetID? Welches KEK Label? Leute, ich wollte nur n Tracker online bringen und nicht gleich Lora studieren!) und zuletzt auch durch die recht hohen Kosten der Clients (meistens ab 100€ aufwärts – lediglich den TrackerD von Dragino gibt’s für 60€, dafür muss man sich aber auch per serieller Konsole damit verbinden, wenn man ihn wieder abschalten möchte). Und dann gibt es noch die Airtime-Beschränkung vom The Things Network (TTN), die maximal 30 Sekunden Sendezeit pro Client zulässt – was bei SF9 und 125kHz ca. 5.000 Zeichen entspricht. Nicht besonders viel – will man alle 10 Minuten eine Position übermitteln, dürften das pro Nachricht gerade noch 30 Zeichen sein, ein String wie {"lat": 52.5162225, "lon": 13.3778965} sind schon 38 Zeichen…)

Doch es gibt einen neuen Stern am Abendhimmel der IoT-Welt: Meshtastic! Doch was ist das eigentlich genau?

Wie gut sind Wettervorhersagen eigentlich?

Ein Thema, das mich schon lange umgetrieben hat ist, wie präzise mittlerweile eigentlich die Vorhersagen von Wetterdiensten sind. Liegen die Prognosen regelmäßig 10 Grad daneben oder funktionieren die Modelle mittlerweile ganz gut? Um das herauszufinden, habe ich im Mai 2021 angefangen, systematisch Vorhersagedaten eines Online-Wetterdienstes zu speichern und zu visualisieren. Zeit also für eine Auswertung!

Wie funktioniert ein Techno-Club?

Der Datenschutz ist in der Winterpause, Bahnreisen gibt’s auch erst im Mai wieder – Zeit also, sich den wirklich wichtigen Themen im Leben zu widmen: Hast du dich eigentlich mal gefragt, wie ein Club funktioniert und wer festlegt, welcher Artist zu welcher Zeit auf welchem Floor auflegt? Nicht? Egal, ab ins Rabbit Hole! Die Wirklichkeit ist nämlich – wie so häufig – viel komplexer als gedacht.

Wann brauche ich ein Joint Controllership Agreement?

Nachdem ich vor einiger Zeit über die Notwendigkeiten und Nicht-Notwendigkeiten von AV-Verträgen geschrieben hatte und der Beitrag bei Google mittlerweile erstaunlich hoch ranked (offenbar gibt es doch genügend Unsicherheit um AV-Veträge…), wird es Zeit für Nachschub: Dieses Mal soll es um ein noch schwammigeres Thema gehen: das ominöse Joint Controllership Agreement!

DSGVO-Kuriositätenkabinett Teil 3

Lange ist es her seit dem letzten Beitrag zum Kuriositätenkabinett. Doch das Internet ist nicht untätig gewesen und bringt jeden Tag fantastische neue Stilblüten des DSGVO-Missbrauchs hervor. Und so gibt es nun endlich mal wieder eine Möglichkeit, den eigenen Puls unkompliziert in die Höhe zu treiben. Also ran an die Halsschlagader!

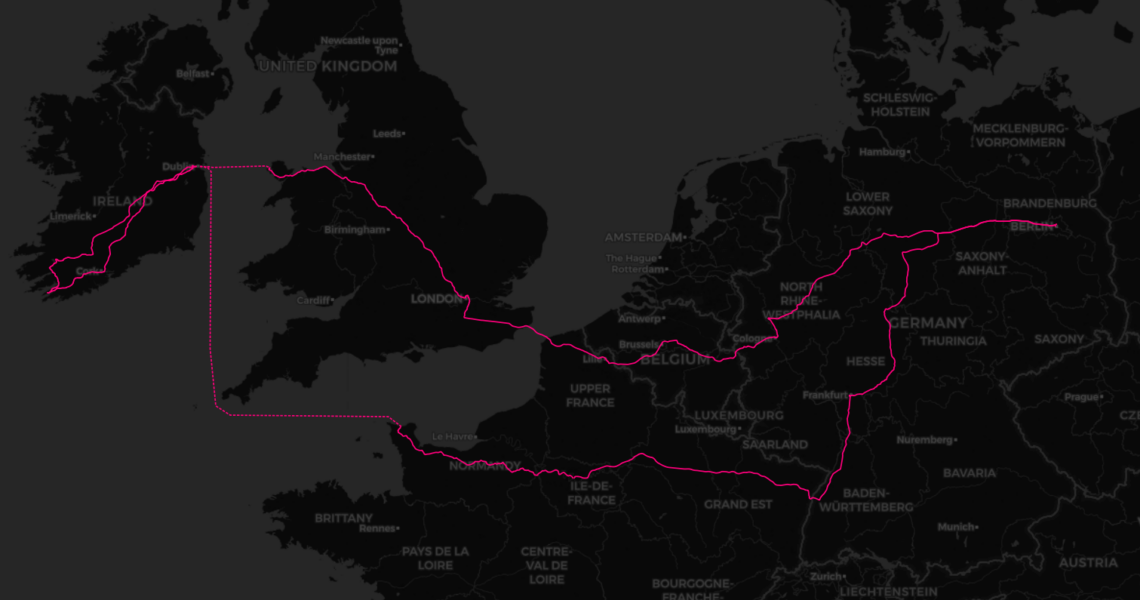

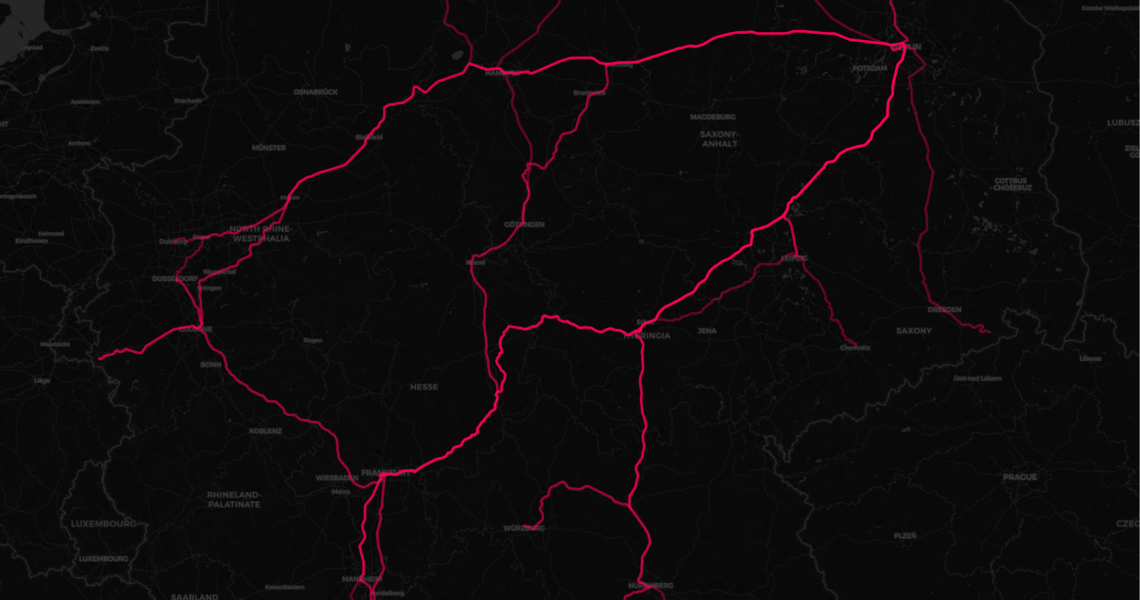

Mit Eurail (Interrail) nach Irland

Ohne Flugzeug nach Irland – geht das? Für einen kleinen Urlaub sollte es dieses Jahr nach Irland gehen – aus Gründen des Klimaschutzes allerdings bestenfalls ohne Flugzeug. Kein Problem sagt Google Maps, die 1.789km schaffst du zu Fuß in 307 Stunden. Fantastisch. Da die Zeit dafür nicht reichte, musste ein Plan B her, warum also nicht Bahn fahren. Easy sagt die DB Reiseauskunft, in 28 Stunden und 50 Minuten bringen wir dich von Berlin Gesundbrunnen bis nach Killarney mit gerade einmal sieben Umstiegen, klingt fast zu schön, um wahr zu sein.

Ganz so eilig muss es dann doch nicht gehen, zumal drei Stunden nachts am Fährterminal zu sitzen und bis sechs Uhr Fähre zu fahren nicht all zu erstrebenswert klingt. Aber so grundsätzlich erschien uns das Vorgehen ganz sinnvoll, also haben wir uns daran gemacht, die Reise etwas auszugestalten, als Basis sollte der Interrail Global Pass dienen.

Über das Märchen vom dezentralen Web 3.0

Das sogenannte Web 3.0 verspricht die große Befreiung des Internets! Durch Blockchains, smart contracts, DApps und Tokens soll der Nutzer von der Macht der Konzerne befreit und mündig gemacht werden. Nutzerzentrierung, Dezentralisierung, Privatsphäre und Sicherheit sind die vier Reiter gegen die Apokalypse und nicht selten ist der Jubel über ihre Ankunft so laut, dass man meinen könnte, sie seien etwas Neues und womöglich würde erst das Web 3.0 ihnen den Weg ebnen. Aber ist das wirklich so?